最近几天总是感觉服务器的流量消失的很快。本来小站就没有多少流量。但是数据流失每天十几个G,就查看了一下服务器日志。这不看不知道,一看吓一跳!

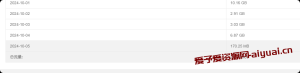

一个页面而已。我又没有大的文件下载上传的。哪儿能用这么多流量。看下图:

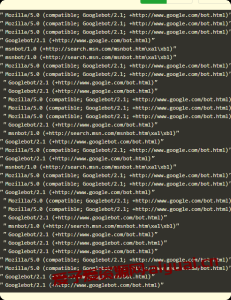

一水的全是google爬虫,几乎每两秒一次。这谁受得了。直接禁止爬虫。

大部分的搜索引擎都遵守robot协议,所以这里要用到一个文件叫:robots.txt 文件 。这个文件要在网站的根目录。禁止爬虫的内容大概如下:

User-agent: *

User-agent: Googlebot

Disallow: /

User-agent: PetalBot

Disallow: /

User-agent: AhrefsBot

Disallow: /

User-agent: Barkrowler

Disallow: /允许所有爬虫代码如下:

User-agent: *

Allow:/也可以只禁止某一个公司的搜索引擎访问某一个文件——比如禁止谷歌爬虫访问admin文件:

User-agent: Googlebot

Disallow: /admin/

User-agent 用户代理,简称UA Disallow 不允许 驳回的意思。allow为允许的意思。

区别各大公司的UA:比如:

Googlebot 谷歌爬虫。

PetalBot 华为花瓣爬虫

Baiduspider百度爬虫

Bingbot 必应

360Spider 360搜索

DotBot国外Moz旗下链接分析网

AhrefsBot是一个国外的搜索引擎蜘蛛

Barkrowler是 国外eXenSa公司下的爬虫

等等等等。。。。

你可以根据自己网站的日志来禁用爬虫。国内一般不会禁百度或者必应。

要看你的网站需求了,请自行斟酌!

本文来源:非特殊说明,本博所有文章均为博主原创。 | 本站部分文章来源于网络,若侵犯了您的权益,请附说明联系删除

如若转载,请注明出处:https://www.aiyuai.cn/archives/651.html | 爱与爱资源网-传递的不仅仅是知识

共有 0 条评论---(要不...来一句吧,实再不行抽一根也中!)